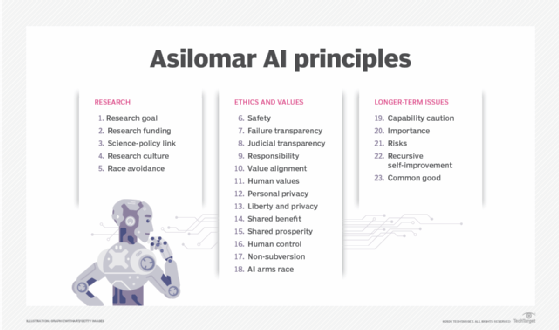

I Principi di Asilomar AI sono 23 linee guida per la ricerca e lo sviluppo dell'intelligenza artificiale (AI). I principi Asilomar delineano i problemi di sviluppo dell'IA, l'etica e le linee guida per lo sviluppo di un'IA benefica e per rendere più facile lo sviluppo dell'IA benefica. I principi sono stati creati alla Asilomar Conference on Beneficial AI nel 2017 a Pacific Grove, in California. La conferenza è stata organizzata dal Future of Life Institute.

Il Future of Life Institute è un'organizzazione senza scopo di lucro la cui missione è "catalizzare e sostenere la ricerca e le iniziative per la salvaguardia della vita e lo sviluppo di visioni ottimistiche del futuro, inclusi modi positivi per l'umanità di seguire la propria rotta considerando le nuove tecnologie e sfide. " L'organizzazione è stata fondata nel 2014 dal cosmologo del MIT Max Tegmark, dal co-fondatore di Skype Jaan Tallinn, dal fisico Anthony Aguirre, Viktoriya Krakovna e Meia Chita-Tegmark. Al momento della stesura di questo documento, 1,273 ricercatori di robotica e intelligenza artificiale hanno aderito ai principi, oltre a 2,541 altri sostenitori di una varietà di settori.

Spesso, i principi sono una chiara dichiarazione di possibili risultati indesiderati, seguiti da una raccomandazione per prevenire un tale evento. Ad esempio, nella categoria etica e valori, la principale corsa agli armamenti dell'IA dichiara che dovrebbe essere evitata una corsa agli armamenti con armi autonome letali.

I principi di Asilomar AI sono suddivisi in 3 categorie: ricerca, etica e valori e questioni a più lungo termine.

Ricerca

- Ricerca: l'obiettivo della ricerca sull'intelligenza artificiale dovrebbe essere quello di creare intelligenza non indiretta, ma intelligenza benefica.

- Finanziamenti per la ricerca - Gli investimenti nell'IA dovrebbero essere accompagnati da finanziamenti per la ricerca per garantirne un uso vantaggioso.

- Collegamento scienza-politica: dovrebbe esserci uno scambio positivo e costruttivo tra ricercatori di IA e responsabili politici.

- Cultura della ricerca: dovrebbe essere promossa una cultura di cooperazione, fiducia e trasparenza tra i ricercatori e gli sviluppatori di intelligenza artificiale.

- Evitare le gare: i team che sviluppano sistemi di intelligenza artificiale dovrebbero cooperare attivamente per evitare tagli agli angoli degli standard di sicurezza.

Etica e valori

- Sicurezza: i sistemi di intelligenza artificiale dovrebbero essere sicuri e protetti per tutta la loro durata operativa e in modo verificabile, ove applicabile e fattibile.

- Trasparenza degli errori: se un sistema di intelligenza artificiale causa danni, dovrebbe essere possibile accertarne il motivo.

- Trasparenza giudiziaria - Qualsiasi coinvolgimento di un sistema autonomo nel processo decisionale giudiziario dovrebbe fornire una spiegazione soddisfacente e verificabile da un'autorità umana competente.

- Responsabilità - I progettisti e i costruttori di sistemi di IA avanzati sono parti interessate nelle implicazioni morali del loro uso, uso improprio e azioni, con la responsabilità e l'opportunità di plasmare tali implicazioni.

- Allineamento ai valori: i sistemi di intelligenza artificiale altamente autonomi dovrebbero essere progettati in modo che i loro obiettivi e comportamenti possano essere certi di allinearsi ai valori umani durante il loro funzionamento.

- Valori umani - I sistemi di IA dovrebbero essere progettati e gestiti in modo da essere compatibili con gli ideali di dignità umana, diritti, libertà e diversità culturale.

- Privacy personale: le persone dovrebbero avere il diritto di accedere, gestire e controllare i dati che generano, dato il potere dei sistemi di intelligenza artificiale di analizzare e utilizzare tali dati.

- Libertà e privacy: l'applicazione dell'IA ai dati personali non deve limitare in modo irragionevole la libertà reale o percepita delle persone.

- Vantaggio condiviso: le tecnologie di intelligenza artificiale dovrebbero avvantaggiare e responsabilizzare quante più persone possibile.

- Prosperità condivisa - La prosperità economica creata dall'intelligenza artificiale dovrebbe essere condivisa ampiamente, a beneficio di tutta l'umanità.

- Controllo umano: gli esseri umani dovrebbero scegliere come e se delegare le decisioni ai sistemi di intelligenza artificiale, per raggiungere gli obiettivi scelti dall'uomo.

- Non sovversione - Il potere conferito dal controllo di sistemi di IA altamente avanzati dovrebbe rispettare e migliorare, piuttosto che sovvertire, i processi sociali e civici da cui dipende la salute della società.

- Corsa agli armamenti dell'IA: dovrebbe essere evitata una corsa agli armamenti con armi autonome letali.

Problemi a lungo termine

- Attenzione sulle capacità: a meno che non vi sia consenso, evitare forti ipotesi sui limiti massimi delle future capacità di intelligenza artificiale.

- Importanza: l'IA avanzata potrebbe rappresentare un profondo cambiamento nella storia della vita sulla Terra e dovrebbe essere pianificata e gestita con cure e risorse adeguate.

- Rischi: i rischi posti dai sistemi di intelligenza artificiale, in particolare i rischi catastrofici o esistenziali, devono essere soggetti a sforzi di pianificazione e mitigazione commisurati al loro impatto previsto.

- Auto-miglioramento ricorsivo: i sistemi di intelligenza artificiale progettati per auto-migliorare ricorsivamente o auto-replicarsi in un modo che potrebbe portare a un rapido aumento della qualità o della quantità devono essere soggetti a rigorose misure di sicurezza e controllo.

- Bene comune - La superintelligenza dovrebbe essere sviluppata solo al servizio di ideali etici ampiamente condivisi, ea beneficio di tutta l'umanità piuttosto che di uno stato o organizzazione.